最近火熱的 DeepSeek R1 模型由於採用了 distill 技術,可以大幅降低計算成本,使得一般人有機會在自家筆電上跑性能逼近 Open AI ChatGPT o1的大語言模型。本文簡單介紹一步安裝在 Macbook Pro 的方法以及使用方法,以下測試採用 Macbook Pro M4 64GB (如果是使用其他晶片組的Macbook 使用者請參閱文末Remark 2)。有興趣的讀者可以先至 Ollama 官網看看最新版本:

Step 1: 在 Macbook Pro M4 上安裝的方式相當容易,只要打開 Mac 內建的終端機 Terminal 輸入:

ollama run deepseek-r1:14b

當出現 send a message (/? for help) 即可開始與之對談:以下展示如果輸入 who are you ? 則 DeepSeek會回答他是 DeepSeek R1。

如果關閉 Terminal視窗,那麼下次要再使用 DeepSeek R1 模型只要再次打開 terminal並且輸入 ollama run deepseek-r1:14b 即可。

Remark: 1. 如果記憶體充足 (64GB以上),可以嘗試跑跑看更大的模型如 ollama run deepseek-r1:32b 或者 ollama run deepseek-r1:70b

2. 注意到如果使用其他 Macbook,如M1, 2, 3晶片組或者 iMac桌機(intel晶片組),則需要先安裝 ollama 到系統中,指令可透過 brew install ollama 達成。接著需啟動 ollama:

brew services start ollama

接著才能使用

ollama run deepseek-r1:14b

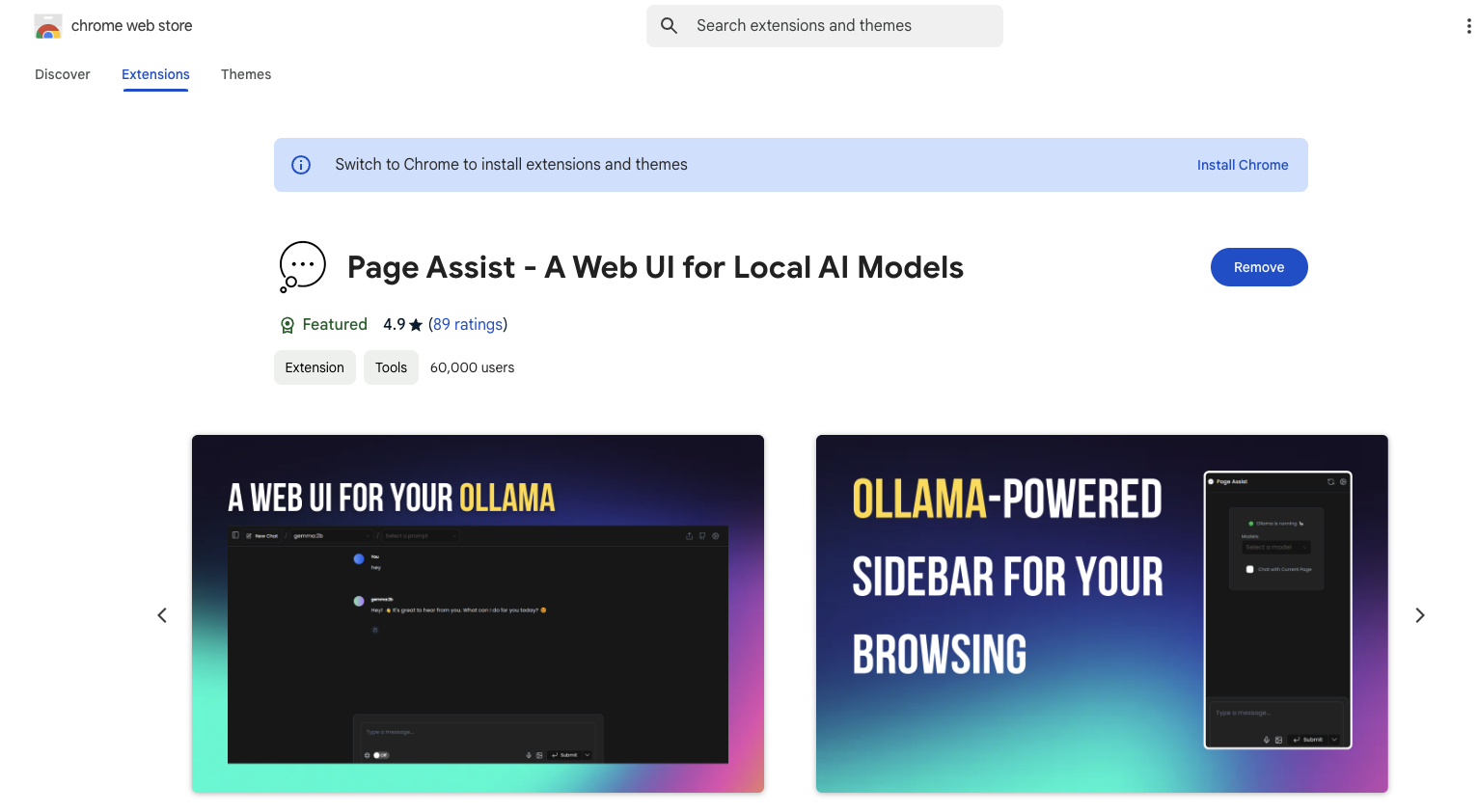

來進行安裝。3. 另外如果想要更方便的使用 DeepSeek R1 本地模型,可以透過使用 WebUi 插件到 Microsoft Edge 或者 Chrome的瀏覽器裡面。比如 Page Assist ,相關網址如下供讀者參考:

請問14b是每秒多少token呢?謝謝

回覆刪除這應該取決於您的硬體配置記憶體大小等等,如果是M4上大概可以每秒10-20個 token。

刪除